МИНИСТЕРСТВО ОБРАЗОВАНИЯ И НАУКИ РЕСПУБЛИКИ КАЗАХСТАН

Некоммерческое акционерное общество

«АЛМАТИНСКИЙ УНИВЕРСИТЕТ ЭНЕРГЕТИКИ И СВЯЗИ»

Кафедра компьютерных технологий

Куралбаев З.К.

ТЕХНОЛОГИИ ВЫСОКОСКОРОСТНЫХ ВЫЧИСЛЕНИЙ

Конспект лекций

для магистрантов, обучающихся по специальности

6М070400 – Вычислительная техника и программное обеспечение

Алматы, АУЭС, 2016

СОСТАВИТЕЛЬ: Куралбаев З.К., д.ф.-м.н., профессор. Технологии высокоскоростных вычислений. Конспект лекций для магистрантов, обучающихся по специальности 6М070400 – Вычислительная техника и программное обеспечение. – Алматы: АУЭС. - 87 с.

Конспект лекций содержит теоретические материалы по дисциплине «Технологии высокоскоростных вычислений», где рассматриваются основные понятия о высокоскоростных вычислениях, технологиях, применяемых для обеспечения высокой скорости решения практических задач и другие вопросы.

Рекомендуется магистрантам всех форм обучения по специальности 6М070400 – Вычислительная техника и программное обеспечение.

Ил., табл. , библиогр. - 11 назв.

Рецензент: канд. техн. наук, профессор Хисаров Б.Д.

Печатается по плану издания Некоммерческого акционерного общества «Алматинский университет энергетики и связи» на 2016 г.

© НАО «Алматинский университет энергетики и связи», 2016 г.

Лекция 1. Введение. Основные понятия о технологиях высокоскоростных вычислений

Цель лекции: дать магистрантам знания о необходимости разработки методов и технологий высокоскоростных вычислений, и о роли их в решении крупных практических задач.

Содержание лекции: Общие принципы организации высокопроизводительных ЭВМ и высокоскоростных вычислений. Уровни создания вычислительных систем.

Известно, что первопричиной создания компьютеров была настоятельная необходимость быстрого проведения вычислительных работ, связанных с решением больших научно-технических задач в различных отраслях и сферах деятельности человека. Решение таких задач и сейчас остается главным стимулом совершенствования компьютеров. В своем развитии компьютеры достигли высокого уровня совершенства. Современные компьютеры обладают большой скоростью выполнения заданий и достаточно просты в обращении. Однако увеличение возможностей компьютеров все же ограничено. И тогда приходится обращаться к суперкомпьютерам.

Появление суперЭВМ в качестве самостоятельного класса вычислительных машин произошло в начале 80-х гг. К середине 1985 г. в мире действовало более 150 таких ЭВМ стоимостью около 10 млн. долл. каждая. Важным фактором, послужившим причиной внезапного роста их популярности, является внезапное и очень резкое увеличение производительности ЭВМ за счет внедрения векторной обработки. В 70-х гг. ряд смелых идей был воплощен в целом классе машин, которые не имели коммерческого успеха, зато проложили путь к созданию нынешнего поколения суперЭВМ. Именно тогда впервые были реализованы принципы параллельной и векторной обработки. В 80-х гг. векторные машины практически стали обыденным явлением.

Согласно распространенному мнению, суперкомпьютер имеет огромную мощность: высокую скорость, большую память, высокую цену. Однако переход от персонального компьютера к суперкомпьютеру для пользователя связан также с большими трудностями. Главная трудность связана с тем, что для них отсутствует пользовательская среда. Кроме этого, разные суперкомпьютеры не совместимы друг с другом.

Общие принципы организации высокопроизводительных ЭВМ и высокоскоростных вычислений. Повышение производительности вычислительных систем предусматривает прежде всего достижение высокой скорости исполнения программ. Такая цель соответствует как требованиям пользователей, заинтересованных в наиболее быстром получении результатов счета, так и тому обстоятельству, что быстродействие определяет общее количество вычислительной работы, которую способна выполнить система за данный отрезок времени.

В ряде прикладных областей повышение скорости вычислений играет большую роль, так как время решения задач на стандартных ЭВМ обычно оказывается слишком большим с точки зрения практического использования результатов. Разумеется, стоимостные факторы и в этом случае имеют существенное значение, однако более важным становится обеспечение самой возможности получения результатов за приемлемое время при минимальной (насколько это удается) стоимости вычислений. Именно в таких прикладных областях и требуются суперЭВМ.

Основными

факторами, определяющими высокую стоимость суперЭВМ, являются:

1. Большие затраты на конструирование, обусловленные сложностью

оборудования и относительно малым серийным выпуском.

2. Высокая стоимость аппаратуры, для создания которой требуются новые

технологии, способные обеспечить предельные для нынешнего уровня развития

техники показатели. На стоимость аппаратуры влияют также увеличение числа

логических элементов, количества выделяемой теплоты в единице объема и другие

подобные факторы.

3. Дорогостоящее программное обеспечение, включающее специальные

средства, которые позволяют реализовать потенциально высокое быстродействие

систем.

Уровни создания вычислительных систем. Область применения методов достижения высокого быстродействия охватывает все уровни создания систем.

На самом нижнем уровне - это передовая технология конструирования и изготовления быстродействующих элементов и плат с высокой плотностью монтажа. В этой сфере лежит наиболее прямой путь к увеличению скорости, поскольку если бы, например, удалось все задержки в машине сократить в К раз, то это привело бы к увеличению быстродействия в такое же число раз. В последние годы были достигнуты огромные успехи в создании быстродействующей элементной базы и адекватных методов монтажа, и ожидается дальнейший прогресс, основанный на использовании новых технологий и снижения размеров устройств. Этот путь, однако, имеет ряд ограничений:

1. Для определенного уровня технологии обеспечивается определенный уровень быстродействия элементной базы: как только он оказался достигнутым, дальнейшее увеличение быстродействия сопровождается огромными расходами вплоть до достижения того порога, за которым уже нет технологий, обеспечивающих большее быстродействие.

2. Более быстродействующие элементы обычно имеют меньшую плотность монтажа, что, в свою очередь, требуют более длинных соединительных кабелей между платами и, следовательно, приводит к увеличению задержек (за счет соединений) и уменьшению выигрыша в производительности.

3. Более быстродействующие элементы обычно рассеивают больше тепла. Поэтому требуются специальные меры по теплоотводу, что еще больше снижает плотность монтажа и, следовательно, быстродействие. Для того чтобы избежать дополнительных расходов, задержек за счет соединений и увеличения рассеяния тепла, целесообразно, по-видимому, применять быстродействующие элементы не везде, а только в тех частях, которые соответствуют <узким местам>. Например, чтобы увеличить скорость сложения, можно применить высокоскоростные схемы только в цепи переноса. Однако путь увеличения быстродействия элементов имеет свои ограничения и может наступить момент, когда станет необходимым или более целесообразным использовать для реализации операции сложения другие способы.

Следующий шаг в направлении повышения быстродействия предполагает уменьшение числа логических уровней при реализации комбинационных схем. Хорошо известно, что любая функция может быть реализована с помощью схемы с двумя логическими уровнями. Однако в сложных системах это приводит к появлению громоздких устройств, содержащих очень большое число вентилей с чрезмерными коэффициентами соединений по входу и выходу. Следовательно, на данном этапе конструкторская задача состоит в создании схем с малым числом логических уровней, которое бы удовлетворяло ограничениям по количеству вентилей и их коэффициентам соединений по входу и выходу. В настоящее время разработаны принципы построения схем, требующих меньшее число вентилей и обладающих меньшими задержками, и предложены методы их создания. В силу присущих ограничений только один этот путь, как правило, не может дать требуемого увеличения производительности.

Следующий уровень охватывает способы реализации основных операций, таких как сложение, умножение и деление. Для того чтобы увеличить cкорость выполнения этих операций, необходимо использовать алгоритмы, которые приводили бы к быстродействующим комбинационным схемам и требовали небольшого числа циклов. В результате успешных исследований и разработок в области арифметических устройств создан ряд алгоритмов, которые могут быть использованы в условиях тех или иных ограничений. С точки зрения применения высокопроизводительных вычислительных машин для научных расчетов особый интерес представляет реализация принципа опережающего просмотра при операциях сложения, сложения с сохраняемым переносом и записи при матричном умножении. Сюда же относятся проблемы использования избыточности при делении и реализация деления в виде цепочки операций умножения.

Далее, быстродействие вычислительных систем может быть повышено за счет реализации аппаратными или программно-аппаратными средствами встроенных сложных команд соответствующих тем или иным функциям, встречающимся во многих практических вычислениях. К таким функциям относятся, например, корень квадратный, сложение векторов, умножение матриц и быстрое преобразование Фурье. Указанные средства позволяют сократить число команд в программах и создают предпосылки для более эффективного использования машинных ресурсов (например, конвейеризованных арифметических устройств). При решении некоторых задач получаемый выигрыш может быть весьма существенным, что особенно хорошо видно на примере рассматриваемых ниже векторных ЭВМ, в которых основную роль играют векторные команды. С другой стороны, непросто определить такие сложные команды, которые бы достаточно часто использовались в широком классе прикладных программ. В то же время исследования процессов выполнения большого числа программ из разных прикладных областей показывают, что существует явное смещение частот использования в направлении небольшого набора простых команд. Этот факт послужил основой для развития подхода, при котором из множества команд выделяется небольшое подмножество простых и часто используемых команд, подлежащих оптимизации. В настоящее время уже разработан ряд экспериментальных и промышленных образцов процессоров, использующих принцип оптимизации сокращенного набора команд. Влияние этого подхода на прогресс в области высокоскоростных вычислений нуждается в оценке.

Еще один резерв, используемый для повышения эффективности работы процессора,- это сокращение временных затрат при обращениях к памяти. Обычные подходы здесь состоят, во-первых, в расширении путей доступа за счет разбиения памяти на модули, обращение к которым может осуществляться одновременно; во-вторых, в применении дополнительной сверхбыстродействующей памяти (кэш-памяти) и, наконец, в увеличении числа внутренних регистров в процессоре. Как показано ниже, использование всех перечисленных способов тесно связано с организацией систем. Длительность исполнения одной команды может быть уменьшена за счет временного перекрытия различных ее фаз. К примеру, вычисление адреса, по которому нужно записать результат, может быть выполнено одновременно с самой операцией. Этот подход требует, разумеется, дополнительного оборудования, поскольку модули памяти не могут быть одновременно задействованы в совмещаемых фазах. Увеличение быстродействия, которое можно при этом достичь, зависит от формата (состава) команды, поскольку именно им определяется наличие независимых фаз.

Наконец, мы подходим к структуре алгоритма, по которому работает система. На этом уровне основной подход к повышению быстродействия состоит в том, чтобы выполнять одновременно несколько команд. Этот подход отличается от того, который реализован в обычной фон-неймановской машине, когда команды исполняются строго последовательно одна за другой. Параллельный подход приводит к различным вариантам архитектуры в зависимости от способа, по которому осуществляется задание очередности следования команд и управление их исполнением. Распараллеливание позволяет значительно увеличить производительность систем при решении широкого класса прикладных задач.

Перечисленные подходы касаются аппаратуры, логической организации и архитектуры систем. Усилия, затрачиваемые в этих областях, имеют своей целью обеспечение необходимого ускорения вычислений на программно-алгоритмическом уровне. На этом уровне должны использоваться либо специальные языки программирования, предоставляющие средства для явного описания параллелизма, либо методы выявления параллелизма в последовательных программах. Кроме того, алгоритм должен обладать внутренним параллелизмом, соответствующим особенностям данной архитектуры. Использование неадекватных алгоритмов и языков способно практически свести на нет возможности для реализации высокоскоростных вычислений, заложенные в архитектуре.

Лекция 2. Организация быстродействующих вычислительных систем

Цель лекции: Дать магистрантам знания и информацию о способах организации высокоскоростных вычислений, ознакомить с основными вычислительными системами.

Содержание лекции: Организация быстродействующих вычислительных систем. Матричная вычислительная система. Векторная вычислительная система. Принципы векторной обработки.

Как отмечалось в предыдущем параграфе, главный организационный принцип, ведущий к повышению быстродействия, подразумевает одновременное выполнение нескольких команд. В этом разделе мы рассмотрим возможные варианты организации систем и покажем, что эффективность их использования связана со структурами вычислительных алгоритмов.

Алгоритм - это описание вычислительного процесса в виде последовательности более простых вычислительных конструкций. Алгоритм включает спецификации этих вычислительных конструкций и отношений следования между ними. Алгоритмические структуры отличаются друг от друга содержанием простых вычислительных конструкций и типом отношения следования.

Вычислительные конструкции, образующие алгоритм, могут быть различными по степени сложности объектами: от простых арифметических операторов до функций. В действительности же концепция алгоритма подразумевает иерархию в том смысле, что вычислительная конструкция в свою очередь может быть описана в виде алгоритма, состоящего из еще более простых вычислительных конструкций. В контексте рассуждений о параллелизме это приводит к понятию детализации параллелизма. Детализацию называют мелкой, если вычислительные конструкции алгоритма являются примитивными (т. е. реализуемыми одной командой), и крупной, если эти конструкции являются сложными (т. е. реализуются с помощью другого алгоритма). Разумеется, спектр значений детализации параллелизма простирается от очень мелкой до очень крупной. Более того, в системах может использоваться комбинированная детализация.

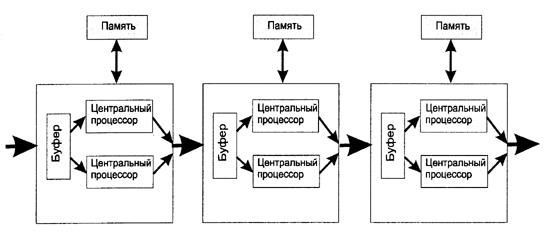

Рисунок 1 - Матричная вычислительная система (левый рисунок)

Рисунок 2 - Конвейерная вычислительная система (правый рисунок)

На этих рисунках ПЭ - процессорные элементы, П - модули памяти.

Основной тип организации векторной вычислительной системы изображен на рисунке 3. Он включает блок обработки команд, осуществляющий вызов и декодирование команд, векторный процессор, исполняющий векторные команды, скалярный процессор, исполняющий скалярные команды, а также память для хранения программ и данных. Последняя делится на главную память и память второго уровня, что обеспечивает ей необходимую емкость и пропускную способность при приемлемой стоимости. Компоненты векторного процессора, также изображенные на рисунке 3, рассмотрены ниже.

Чтобы показать, какой выигрыш в производительности дает векторная машина, рассмотрим операцию сложения двух векторов на рисунке 4,а изображены скалярная программа и временная диаграмма ее исполнения на обычной ЭВМ, в которой реализован опережающий просмотр в сочетании с конвейерным исполнением операций. На рисунке 4,б изображены соответствующая векторная программа и временная диаграмма.

Принципы векторной обработки. Принцип векторной обработки основан на существовании значительного класса задач использующих операции над векторами. Алгоритмы этих задач в соответствии с терминологией Флинна относятся к классу ОКМД (одиночный поток команд, множественный поток данных). Реализация операций обработки векторов на скалярных процессорах с помощью обычных циклов ограничивает скорость вычислений по следующим причинам.

Рисунок 3 - Структура векторной вычислительной системы

Рисунок 4 - Вычисление суммы двух векторов.

а - на скалярном процессоре; б - на векторном процессоре

1. Перед каждой скалярной операцией необходимо вызывать и декодировать скалярную команду.

2. Для каждой команды необходимо вычислять адреса элементов данных.

3. Данные должны вызываться из памяти, а результаты запоминаться в памяти. В больших ЭВМ память выполняется, как правило, в виде набора модулей, доступ к которым может осуществляться одновременно. В условиях когда каждая команда вырабатывает свой собственный запрос к памяти, такой раздробленный доступ может стать причиной возникновения конфликтов обращения к памяти, препятствующих эффективному использованию ее потенциальной пропускной способности. 4

4. Необходимо осуществлять упорядочение выполнения операций в функциональных устройствах. В целях увеличения производительности эти устройства строятся по конвейерному принципу. Эффективному использованию конвейерных устройств препятствует последовательная “природа” оператора цикла.

5. Реализация команд построения циклов (счетчик и переход) сопровождается накладными расходами. Кроме того, наличие в цикле команды перехода препятствует эффективному использованию принципа опережающего просмотра.

Влияние перечисленных отрицательных факторов уменьшается при введении векторных команд, с помощью которых задается одна и та же операция над элементами одного или нескольких векторов, и организации, системы, которая обеспечивает эффективное исполнение таких команд. Этот подход реализуется в системах двух типов: матричных и векторно-конвейерных.

Матричная система состоит из множества процессорных элементов (ПЭ), организованных таким образом, что они исполняют векторные, команды, задаваемые общим для всех устройством управления, причем каждый ПЭ работает с отдельным элементом вектора. ПЭ соединены через коммутационное устройство с многомодульной памятью. Исполнение векторной команды включает чтение из памяти элементов векторов, распределение их по процессорам, выполнение заданной операции и засылку результатов обратно в память.

В векторно-конвейерной системе, напротив, имеется один (или небольшое число) конвейерный процессор, выполняющий векторные команды путем засылки элементов векторов в конвейер с интервалом, равным длительности прохождения одной, стадии обработки. При этом скорость вычислений зависит только от длительности стадии и не зависит от задержек в процессоре в целом.

Оба подхода в принципе позволяют достичь значительного ускорения по сравнению со скалярными машинами. Более того, ускорение в системах матричного типа может быть больше, чем в конвейерных, поскольку увеличить число процессорных элементов проще, чем число ступеней в конвейерном устройстве. В настоящее время созданы и успешно применяются системы обоих типов. К наиболее значительным представителям семейства матричных систем относятся одна из первых крупных разработок – ILLIAC IV - системы DAP фирмы ICL, BSP фирмы Burrougs и МРР фирмы Goodyear. Класс конвейерных систем включает такие системы, как STAR100 и Суbег 205 фирмы СDС, Сгау-1 фирмы Сгау >Research, S-810 фирмы НIТАСНI, SХ NЕС и FАСОМ, VР-200 фирмы Fujitsu. Тот факт, что большинство суперЭВМ относится к классу конвейерных систем, свидетельствует, похоже, о том, что для современного уровня технологии такие системы являются более гибкими и эффективными с точки зрения стоимости.

Лекция 3. Факторы, снижающие пропускную способность

Цель лекции: Изучение способов скалярной и конвейерной обработки данных. Знакомство с зависимостями по данным и по управлению.

Содержание лекции: Скалярная обработка. Стартовое время конвейера. Зависимости по данным. Зависимости по управлению.

Существует ряд факторов, приводящих к тому, что при выполнении реальных программ производительность векторных ЭВМ оказывается значительно ниже максимально возможной. Мы обсудим наиболее важные из них и покажем, какие показатели могут служить мерой снижения производительности.

Скалярная обработка. Невозможно построить реальную прикладную программу, состоящую только из векторных операций. Значительная часть вычислений остается скалярной, причем некоторые скалярные команды служат для подготовки, векторных команд и управления их прохождением. Поскольку векторные устройства не обеспечивают эффективного исполнения этих команд, в состав оборудования входит скалярный процессор. Всякий раз, когда исполнение какой-либо скалярной операции не полностью перекрывается по времени векторными вычислениями, происходит снижение производительности.

Величина снижения может быть получена исходя из доли скалярных операций (f)и отношения максимальной пропускной способности в векторном режиме к пропускной способности в скалярном режиме (r). В итоге получим коэффициент снижения пропускной способности:

d=Rmax/R=f*r+(1-f) ,

где Rmax - максимальная пропускная

способность (полная загрузка всех конвейеров), R - реальная пропускная

способность, ![]() -

отношение максимальной пропускной способности в векторном режиме к пропускной

способности в скалярном режиме.

-

отношение максимальной пропускной способности в векторном режиме к пропускной

способности в скалярном режиме.

Как видно из рисунке 1, снижение производительности может быть весьма значительным.

Так, например, при f = 0,1 и r =50 реальная производительность меньше максимальной в 5,9 раза. Конкретные значения f и r варьируются в зависимости от системы и прикладной области

Рисунок 1 - Коэффициент снижения производительности

Стартовое время конвейера. Максимальная пропускная способность конвейерной машины достигается при обработке длинных векторов, поскольку только в этом случае доля времени, затрачиваемого на начальном этапе (загрузка параметров, реконфигурация, ожидание первого результата), оказывается максимальной. Следовательно, пропускная способность R как функция длины вектора l определяется выражением:

![]()

где ts - время прохождения одной стадии конвейера, tstart - стартовое время конвейера.

Типичными для современных суперЭВМ являются следующие цифры: tstart = 1000нс, ts = 15нс. Из графика этой функции, приведенного на рис.4.2, видно, что при малых длинах векторов пропускная способность может быть значительно ниже максимальной. Таким образом, необходимо стремиться к тому, чтобы длина векторов была возможно большей, а стартовое время меньшим.

Наличие стартового времени приводит к тому, что векторная обработка оказывается эффективней скалярной лишь начиная с некоторого порога длины векторов. Соответствующей количественной мерой может служить коэффициент ускорения вычислений как функция длины вектора, а именно:

![]()

Рисунок 2 - Пропускная способность, как функция длины вектора

где r - введенное ранее отношение максимальных пропускных способностей при векторном и скалярных режимах соответственно. Отсюда найдем приближенную пороговую длину вектора:

![]()

где tscalar - время выполнения скалярных операций.

Зависимости по данным. Условием работы процессора в режиме пиковой производительности является одновременное исполнение нескольких команд, обеспечивающее постоянную занятость всех функциональных устройств. При наличии зависимостей по данным между командами, т.е. когда одна команда не может исполняться до завершения другой, это условие нарушается. Такого рода зависимость может существовать между любыми двумя командами. Примером двух зависимых векторных команд может служить следующий фрагмент:

![]()

![]()

В этом случае снижение производительности может быть предотвращено с помощью образования цепочек операций, когда исполнение данной векторной команды начинается сразу, как только образуются компоненты участвующих в ней векторных операндов (см. рисунок 2.3). Данный метод может применяться в большом числе практических случаев, однако не всегда.

Например, его нельзя использовать в следующем примере:

![]()

поскольку для начала исполнения второй команды необходимо вычислить скалярный результат первой.

Рисунок 2.3 - Образование цепочки операций

Зависимости по управлению. Данный тип зависимости существует двумя командами в ситуациях до тех пор, пока не завершится исполнение предыдущей команды, и остается неизвестным, какая из двух окажется следующей. Такая зависимость обычно порождается условными переходами и является одним из наиболее существенных отрицательно влияющих на производительность факторов в скалярных процессорах с опережающим просмотром.

В векторных ЭВМ, где часть операторов цикла заменена векторными командами, влияние данного фактора несколько ослаблено, однако остается еще значительным.

При наличии зависимостей данного типа, когда команда, с которой начинается та или иная ветвь, остается неизвестной до тех пор, пока не завершится исполнение предыдущей команды и последовательность не прервется, в потери времени входит полный цикл обработки команды: вызов, декодирование и др.

Для уменьшения этих потерь различные конструктивные средства: предварительный вызов начальных команд обеих ветвей, являющихся возможными продолжениями данной; использование нескольких командных буферов для хранения разных участков программ; хранение, задержанных ветвей в виде, позволяющем загрузить процессор сразу после завершения выбора ветви.

Эти методы, разработаны для высокопроизводительных скалярных процессоров.

Лекция 4. Реализация условных операторов и ограничения, налагаемые на производительность

Цель лекции: Изучение способов использования условных операторов и знакомство с ограничениями при высокоскоростных вычислениях.

Содержание лекции: Реализация условных операторов. Нахождение команд вне буфера. Ограничения, связанные с локальной памятью. Ограничения, связанные с механизмом адресации и недостаточно эффективной пропускной способностью памяти. Ограничения, связанные с конфликтами доступа к памяти. Ограничения, связанные со специализированными арифметическими устройствами. Ограничения, связанные с объемом памяти. Оценка общей производительности.

Векторная команда как единое целое не может быть выполнена в ситуациях, когда вид операции над элементами вектора зависит от условия, как, например, в следующем фрагменте:

if

![]() then

then ![]() else

else

![]()

Один из возможных выходов состоит в том, чтобы выполнить все операции в скалярном режиме, однако, как мы видели раньше, это привело бы к резкому снижению производительности, Более перспективной альтернативой является использование для управления векторной операцией так называемого вектора режима. Это битовый вектор, содержащий такое же число элементов, как и каждый из векторов в управляемой операции. Управление в данном случае означает то, что операция выполняется только над теми элементами векторов, которым соответствует значение 1 в одноименных позициях вектора режима. Безусловно описанный способ лучше, чем скалярный, однако и при нем все еще остаются факторы, снижающие производительность.

Нахождение команд вне буфера. Как уже отмечалось при рассмотрении базовой структуры процессора, для обеспечения высокой производительности необходимо заранее вызывать команды из памяти и помещать в специальный буфер. Наличие такого буфера позволяет считывать из памяти целые блоки следующих друг за другом команд. Если эти команды находятся в памяти, организованной по принципу чередования адресов, то такая выборка может осуществляться параллельно со всеми преимуществами, которые представляет многомодульная организация памяти.

Ограничения, связанные с локальной памятью. Для поддержания высокой скорости конвейера арифметических операций операнды должны, интенсивно поступать из памяти. Это, в свою очередь, требует разделения памяти, на модули с возможностью одновременного доступа, а также включения буфером для операндов и результатов. Такой 6уфер сглаживает изменения пропускной способности тракта обмена данными между памятью и арифметическими устройствами, а также позволяет осуществлять выборку из памяти~ элементов векторов в порядке, отличающемся от того, который должен быть на входе обрабатывающих устройств. Это, как будет показано далее, существенно расширяет диапазон прикладных задач, которые могут эффективно решаться в векторном режиме. Буферная память служит также для хранения результатов, которые в последующих векторных командах выступают в качестве операндов.

По способу организации локальной памяти векторные процессоры делятся на два класса. К первому относятся те, в которых команды исполняются по принципу “регистр-регистр”, а ко второму - по принципу “память-память”. В первом случае локальная память представляет собой набор векторных регистров, адресуемых в командах, а во втором: локальную память, работающую как - буферное устройство и остающуюся невидимой для программиста. Основным преимуществом систем первого класса состоят в следующем: команды, в которых указаны короткие адреса регистров, имеют меньшую длину; промежуточные результаты естественным образом хранятся на регистрах; облегчается процесс контроля зависимостей между командами. Главный недостаток данного подхода связан с ограниченностью разрядности и числа регистров.

Ограничения, связанные с механизмом адресации и недостаточно эффективной пропускной способностью памяти. Поскольку время доступа к памяти существенно превышает длительность одной стадии обрабатывающего конвейера, а в процессе исполнения программ требуются одновременные обращения к памяти за различными операндами, обеспечение адекватной пропускной способности памяти в векторном режиме, когда элементы векторов-операндов занимают последовательный ряд адресов достигается за счет организации памяти в виде нескольких модулей и применения принципа чередования адресов (интерливинг/расслоение).

Это позволяет даже при максимальной пропускной способности осуществлять бесконфликтный доступ к блокам последовательно адресуемых элементов векторов.

Ограничения, связанные с конфликтами доступа к памяти. К ограничивающим факторам относятся конфликты доступа, возникающие при одновременном появлении нескольких разных - о6ращений к памяти. Необходимым условием работы системы с максимальной производительностью является своевременное считывание команд из памяти, вызов скалярных и векторных операндов и запись зарабатываемых результатов.

Указанные запросы реализуются через равные порты и “мешают” друг другу, что приводит к неполному использованию пропускной способности памяти. Для того чтобы отрицательное влияние этих конфликтов на общую производительность было минимальным, устройство управления доступом к памяти должно соответствующим образом планировать порядок обслуживания запросов.

Например, в системе Cray X-MP память разделена на четыре секции, каждая из которых имеет четыре порта: три обслуживают запросы процессоров и один обслуживает ввод/вывод. Порты А и В предназначены для чтения, а порт С для записи. Возникающие конфликты разрешаются с помощью системы приоритетов, причем последние зависят от вида обращения и времени поступления. Из сказанного ясно, что получить адекватную оценку производительности можно только путем прогонки программ на реальном оборудовании.

Ограничения, связанные со специализированными арифметическими устройствами. Максимальная пропускная способность системы достигается только в том случае, когда все арифметические устройства используются полностью. Как было отмечено выше, полной загрузке этих устройств препятствует наличие зависимостей по данным и по управлению. Другим ограничивающим фактором уменьшающим эффективную производительность, является специализированность арифметических устройств, состоящих из устройства сложения, устройства умножения и т.д. В этом случае полное использование арифметического оборудования возможно только на специально подобранной смеси векторных и скалярных операций. Следовательно, реальная производительность зависит от состава операций в конкретной программе.

Ограничения, связанные с объемом памяти. При решении многих прикладных задач массивы данных оказываются столь большими, что не могут уместиться в главной памяти. В этих случаях часть данных приходится хранить в памяти второго уровня и осуществлять подкачку и удаление информации в процессе счета. Размер главной памяти, скорость подкачки, способ сегментирования - все эти факторы оказывают значительное влияние на производительность.

Оценка общей производительности. Ввиду сложного характера взаимодействия между факторами, снижающими производительность, и зависимостью степени влияния этих факторов от конкретных программ оценка призводительности в целом должна осуществляться на специально подобранных прикладных задачах.

Приближенная оценка может быть получена с помощью контрольных задач, состоящих из набора типовых тестовых программ. Проблема, связанная с такой приближенной оценкой, заключается в трудности определения термина <типовой>. Искусственные контрольные задачи, содержащие в нужном соотношении скалярные операции и векторные команды различных типов, могут дать лишь самые грубые оценки.

Недостаток данного метода состоит в том, что он не учитывает взаимосвязи между командами, роль которых в формировании реального показателя производительности может быть значительной. Одними из наиболее широко используемых для оценки векторных машин контрольных задач являются так называемые Ливерморские циклы, разработанные в Национальной лаборатории им. Лоуренса в г. Ливерморе (США). Интересно отметить, что для всех типов машин оценки, полученные на разных циклах, сильно отличаются друг от друга.

Например, согласно этим оценкам производительность Сrау-1 колеблется от 3 до 90 млн. операций с плавающей запятой в секунду. Кроме того, хотя наилучшие и наихудшие с точки зрения производительности циклы практически одни и те же для всех машин, характер зависимости производительности от типа цикла на разных машинах существенно отличается один от другого.

Это подтверждает тезис о специфическом влиянии на производительность тех или иных особенностей организации систем. На производительность оказывает влияние также качество используемого компилятора.

Лекция 5. Архитектура высокопроизводительных ЭВМ

Цель лекции: Знакомство с основными видами архитектуры высокопроизводительных ЭВМ и их возможностями.

Содержание лекции: Рассматриваются различные виды архитектуры ЭВМ, их основные характеристики. Информация о классификации высокопроизводительных ЭВМ.

Прежде чем мы перейдем к изучению методов и средств параллельного программирования, полезно познакомиться с некоторыми особенностями устройства высокопроизводительных вычислительных систем. Преимуществом использования языков программирования высокого уровня является универсальность программ и их простая переносимость между различными компьютерами (разумеется, если на этих компьютерах имеется необходимое программное обеспечение, прежде всего, трансляторы).

Следует учитывать, что эффективность выполнения параллельных программ определяется не только аппаратной частью, но и способностью транслятора генерировать эффективный исполняемый код. Оба эти фактора взаимосвязаны и порой сложно определить, какой из них имеет решающее значение.

Обычно, программист полагается на эффективность транслятора, считая, что при грамотном программировании сгенерированный транслятором исполняемый код будет обладать хорошими показателями по быстродействию; в этом случае отпадает необходимость в применении языков низкого уровня (ассемблеров), требующих глубоких знаний архитектуры процессора.

Но, бывает и так, что программисту все же требуется знание устройства компьютера, принципов и даже некоторых деталей его работы. Можно привести следующий пример. При разработке программ для параллельных ЭВМ используются специализированные библиотеки, позволяющие организовать обмен данными между отдельными подзадачами и их синхронизацию. Для эффективной организации обмена данными необходимо знать, как происходит пересылка информации между процессорами, какова ее скорость и т. д.

В вычислительной технике используются три термина, связанные с устройством электронно-вычислительной машины:

Архитектура компьютера — это описание основных компонентов компьютера и их взаимодействия. Можно считать, что архитектура — это те атрибуты вычислительной системы, которые видны программисту: набор команд, разрядность машинного слова, механизмы ввода/вывода, методы адресации. Можно дать и другое определение: архитектура — это внутренняя структура системы или микропроцессора, которая определяет их функциональные возможности и быстродействие.

Организация компьютера — это описание конкретной реализации архитектуры, ее воплощения "в железе". Оно включает перечень используемых сигналов управления, интерфейсов, технологий памяти, реализацию арифметических, логических и других операций. Так, умножение может быть реализовано на аппаратном уровне или посредством многократного повторения операции суммирования.

Ряд суперкомпьютеров Cray, например, имеют сходную архитектуру. С точки зрения программиста у них одинаковое число внутренних регистров, используемых для временного хранения данных, одинаковый набор машинных команд, одинаковый формат представления данных. Организация же компьютеров Cray разных моделей может существенно различаться. У них может быть разное число процессоров, разный размер оперативной памяти, разное быстродействие и т. д.

Схема компьютера — детальное описание его электронных компонентов, их соединений, устройств питания, охлаждения и др. Программисту довольно часто требуется знание архитектуры компьютера, реже — его организации и никогда — схемы компьютера.

Действительно, зачем специалисту, который занимается, например, расчетом прочностных свойств новой модели автомобиля, знать, какая марка вентилятора охлаждает процессор компьютера во время выполнения его программы?

Классификация Флинна. Одной из наиболее известных схем классификации компьютерных архитектур является таксономия Флинна, предложенная Майклом Флинном в 1972 году. В ее основу положено описание работы компьютера с потоками команд и данных. В классификации Флинна имеется четыре класса архитектур:

1. SISD (Single Instruction Stream — Single Data Stream) — один поток команд и один поток данных.

2. SIMD (Single Instruction Stream — Multiple Data Stream) — один поток команд и несколько потоков данных.

3. MISD (Multiple Instruction Stream — Single Data Stream) — несколько потоков команд и один поток данных.

4. MIMD (Multiple Instruction Stream — Multiple Data Stream) — несколько потоков команд и несколько потоков данных.

Рассмотрим эту классификацию более подробно.

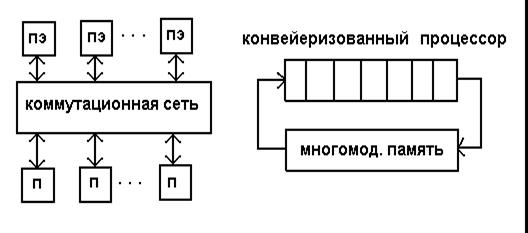

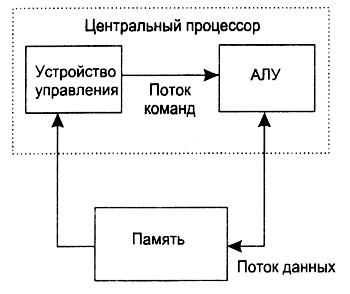

SISD-компьютеры. SISD-компьютеры (Рисунок 1) — это обычные последовательные компьютеры, выполняющие в каждый момент времени только одну операцию над одним элементом данных. Большинство современных персональных ЭВМ принадлежат именно этой категории.

Многие современные вычислительные системы включают в свой состав несколько процессоров, но каждый из них работает со своим независимым потоком данных, относящимся к независимой программе. Такой компьютер является, фактически, набором SISD-машин, работающих с независимыми множествами данных.

Рисунок 1 - Схема SISD-компьютера

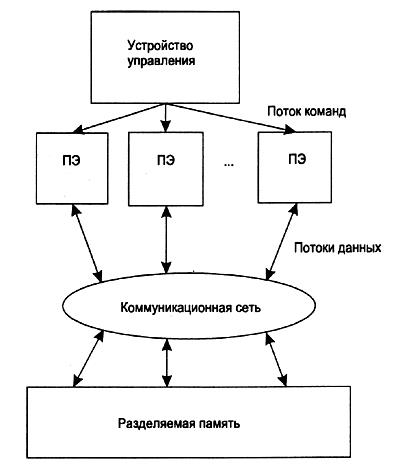

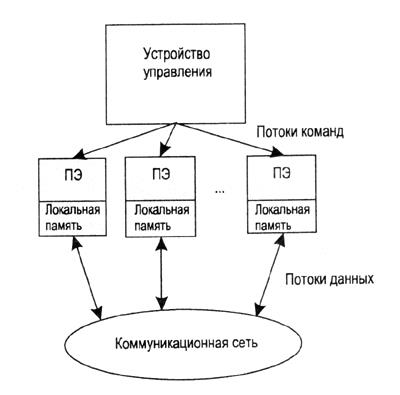

SIМD-компьютеры. SIMD-компьютеры (Рисунки 2 и 3) состоят из одного командного процессора (управляющего модуля), называемого контроллером, и нескольких модулей обработки данных, называемых процессорными элементами (ПЭ). Количество модулей обработки данных таких машин может быть от 1024 до 16 384.

Управляющий модуль принимает, анализирует и выполняет команды. Если в команде встречаются данные, контроллер рассылает на все ПЭ команду, и эта команда выполняется либо на нескольких, либо на всех процессорных элементах.

Процессорные элементы в SIMD-компьютерах имеют относительно простое устройство, они содержат арифметико-логическое устройство (АЛУ), выполняющее команды, поступающие из устройства управления (УУ), несколько регистров и локальную оперативную память. Одним из преимуществ данной архитектуры считается эффективная реализация логики вычислений.

До половины логических команд обычного процессора связано с управлением процессом выполнения машинных команд, а остальная их часть относится к работе с внутренней памятью процессора и выполнению арифметических операций. В SIMD-компьютере управление выполняется контроллером, а "арифметика" отдана процессорным элементам.

Подклассом SIMD-компьютеров являются векторные компьютеры. Пример такой вычислительной системы — Hitachi S3600.

MISD-компьютеры. Вычислительных машин такого класса мало. Один из немногих примеров - систолический массив процессоров, в котором процессоры находятся в узлах регулярной решетки. Роль ребер в ней играют межпроцессорные соединения, все ПЭ управляются общим тактовым генератором. В каждом цикле работы любой ПЭ получает данные от своих соседей, выполняет одну команду и передает результат соседям. На рисунке 4 дана схема фрагмента систолического массива

Рисунок 2 - Схема SIMD-компьютера с разделяемой памятью

Рисунок 3 - Схема SIMD-компьютера с распределенной памятью

Рисунок 4 - Схема MISD-компьютера

Лекция 6. MIMD-компьютеры

Цель лекции: Знакомство с одним из популярных видов компьютеров, с возможностями и особенностями MIMD-компьютеров.

Содержание лекции: Основные характеристики и возможности MIMD-компьютеров, архитектура фон Неймана.

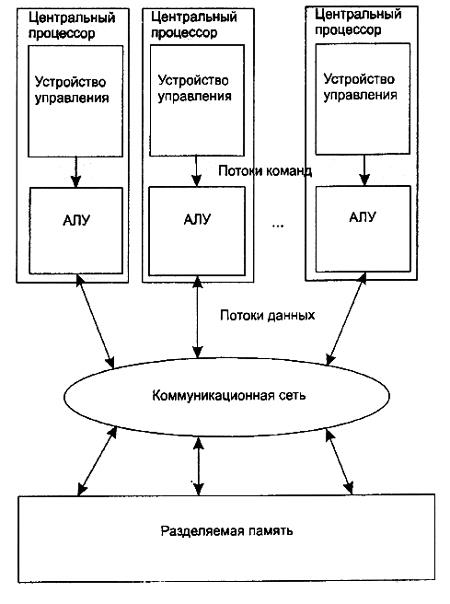

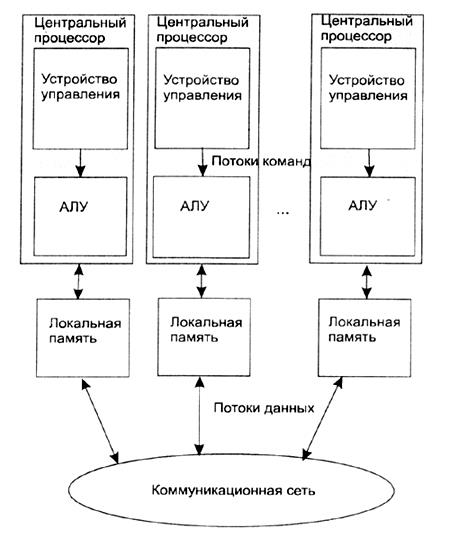

Этот класс архитектур (Рисунки 1.5 и 1.6) наиболее богат примерами успешных реализаций. В него попадают симметричные параллельные вычислительные системы, рабочие станции с несколькими процессорами, кластеры рабочих станций и т. д. Довольно давно появились компьютеры с несколькими независимыми процессорами, но вначале на них был реализован только принцип параллельного исполнения заданий, т. е. на разных процессорах одновременно выполнялись независимые программы. Разработке первых компьютеров для параллельных вычислений были посвящены проекты под условным названием СМ* и С.ММР в университете Карнеги (США). Технической базой для этих проектов были процессоры DEC PDP-11. В начале 90-х годов прошлого века именно MIMD-компьютеры вышли в лидеры на рынке высокопроизводительных вычислительных систем.

Рисунок 5 - Схема MIMD-компьютера с разделяемой памятью

Имеются и гибридные конфигурации, в которых, например, объединены несколько SIMD-компьютеров, в результате чего получается MSIMD-компьютер, позволяющий создавать виртуальные конфигурации, каждая из которых работает в SIMD-режиме.

Классификация Флинна не дает исчерпывающего описания разнообразных архитектур MIMD-машин, порой существенно отличающихся друг от друга. Например, существуют такие подклассы MIMD-компьютеров, как системы с разделяемой памятью и системы с распределенной памятью. Системы с разделяемой памятью могут относиться по классификации Флинна как к MIMD, так и к SIMD-машинам. То же самое можно сказать и о системах с распределенной памятью.

Развитием концепции MIMD-архитектуры с распределенной памятью является распределенная обработка, когда вместо набора процессоров в одном корпусе используются компьютеры, связанные достаточно быстрой сетью. Концептуального отличия от MIMD-архитектуры с распределенной памятью нет, а особенностью является медленное сетевое соединение.

Рисунок 6 - Схема MIMD-компьютера с распределенной памятью

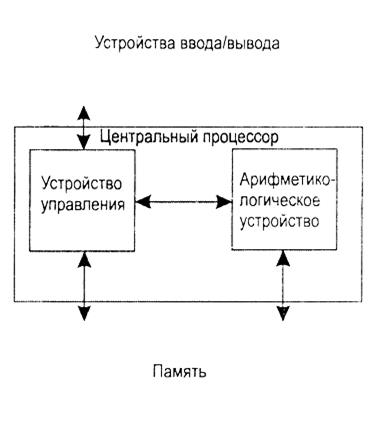

Традиционная архитектура фон Неймана. Традиционная фон-неймановская архитектура компьютера представлена на рис. 1.7. Она основана на следующих принципах:

- программа хранится в компьютере;

- программа во время выполнения и необходимые для ее работы данные находятся в оперативной (главной) памяти;

- имеется арифметико-логическое устройство, выполняющее арифметические и логические операции с данными;

- имеется устройство управления, которое интерпретирует команды, выбираемые из памяти, и выполняет их;

- устройства ввода и вывода (ВВ) используются для ввода программ и данных и для вывода результатов расчетов. Работают под управлением УУ.

Рисунок 7 - Схема компьютера фон Неймана

Устройство управления и арифметико-логическое устройство (АЛУ) вместе составляют центральный процессор (ЦП). Можно считать, что все остальные функциональные блоки компьютера обслуживают АЛУ, а оно выполняет основную работу. Арифметические операции выполняются с целыми и вещественными числами, для представления которых используется двоичный формат. Для отрицательных значений применяется дополнительный код, что позволяет упростить реализацию арифметических и логических операций. Управляющее же устройство управляет работой остальных функциональных узлов компьютера.

В состав "традиционного" фон-неймановского компьютера входит один ЦП, основной задачей которого является выполнение машинных команд, выбираемых из оперативной памяти по очереди, одна за другой. Устройство управления интерпретирует очередную команду, которая входит в набор команд процессора, включающих арифметические и логические операции, операции пересылки данных и некоторые другие. Затем выполняется выборка данных, их обработка и запись результата выполнения в оперативную память. ЦП имеет набор регистров — устройств для временного хранения промежуточных результатов и данных, необходимых для выполнения команд (операндов).

Таким образом, основными компонентами компьютера являются:

- центральный процессор и оперативная память, образующие ядро системы;

- вторичная ("внешняя") память и устройства ввода/вывода, образующие "периферию";

- коммуникации между компонентами системы, осуществляемые посредством шин.

Лекция 7. О параллельной обработке данных

Цель лекции: Знакомство с проблемами повышения производительности компьютеров и методами параллельной обработки данных.

Содержание лекции: Проблема повышения производительности компьютеров. Параллельная обработка данных. Конвейерная обработка данных. Информационная зависимость и графы информационной зависимости.

Проблема повышения производительности компьютеров. В последние годы в повышении производительности компьютеров достигнуты колоссальные результаты. По закону Мура производительность обычного компьютера удваивается каждые полтора года. В качестве примера можно привести следующую информацию:

- на одном из первых компьютеров EDSAC (1949 год) можно было выполнять 2n арифметических операций за 18n миллисекунд, т.е. в среднем 100 арифметических операций в секунду (время такта 2 микросекунды);

- на одном узле современного суперкомпьютера HPSD (Hewlet-Packard Superdome) можно выполнять около 192 миллиардов арифметических операций в секунду (время такта приблизительно 1,3 нс, процессор PA-8700, 750 МГц).

Здесь возникает следующий вопрос: за счет чего достигнута такая производительность, которая составляет примерно два миллиарда раз, при увеличении тактового времени всего 1500 раз?

Ответ можно найти в использовании новых решений в архитектуре компьютеров, а также в использовании принципа параллельной обработки данных.

Для дальнейших изложений материалов данной лекции необходимо дать некоторые определения, которые часто будут использованы.

Команда, у которой все аргументы должны быть скалярными величинами, называется скалярной командой. Если хотя бы один аргумент команды может быть вектором, то такая команда называется векторной командой.

Любой программист начинает свою программистскую жизнь с создания последовательных программ. Последовательная модель программирования является традиционной. Но существуют и другие модели программирования. Одной из них является параллельная модель. Ее особенности, достоинства и связанные с ней проблемы обсуждаются в данной главе.

Рисунок 1 - Информационный граф алгоритма

Разработка параллельной программы для программиста, привыкшего к последовательной модели программирования, может оказаться на первых порах непростым делом. Ведь в этом случае придется задуматься не только о привычных вещах, таких как структуры данных, последовательность их обработки, интерфейсы, но и об обменах данными между подзадачами, входящими в состав параллельного приложения, об их согласованном выполнении и т. д. Однако, приобретя навык параллельного программирования, начинаешь понимать, что параллельное программирование — это... просто. Иногда написать параллельную программу для обработки массива данных оказывается проще, чем последовательную.

Последовательная и параллельная модели программирования. Совокупность приемов программирования, структур данных, отвечающих архитектуре гипотетического компьютера, предназначенного для выполнения определенного класса алгоритмов, называется моделью программирования. Напомним, что алгоритм — это конечный набор правил, расположенных в определенном логическом порядке и позволяющий исполнителю решать любую конкретную задачу из некоторого класса однотипных задач. Нижний уровень иерархии включает примитивные операции.

Рисунок 2 - Полностью последовательный алгоритм

Описание алгоритма является иерархическим, его сложность зависит от степени его детализации. На самом верхнем уровне иерархии находится задача в целом. Ее можно считать некоторой обобщенной операцией.

Алгоритм можно представить в виде диаграммы — информационного графа. Информационный граф описывает последовательность выполнения операций и взаимную зависимость между различными операциями или блоками операций. Узлами информационного графа являются операции, а однонаправленными дугами — каналы обмена данными (рисунок 1). Понятие операции может трактоваться расширенно. Это может быть оператор языка, но может быть и более крупный блок программы.

В информационном графе каждый узел задается парой (п, s), где п — имя узла, s — его размер. Размер узла определяется количеством простейших операций, входящих в его состав. Дуги характеризуются значениями (v, d), где v — пересылаемая переменная, a d — время, затрачиваемое на ее пересылку. Слияние нескольких узлов в один (упаковка узлов) уменьшает степень детализации алгоритма, но увеличивает количество дуг, выходящих из вершины графа. Упаковка позволяет скрыть несущественные на данном этапе разработки коммуникации и снизить затраты на их планирование.

На рисунках 2 и 3 представлены два предельных случая информационного графа. Первый из них соответствует последовательной, а второй — параллельной модели вычислений.

Рисунок 3 - Полностью параллельный алгоритм

Традиционной считается последовательная модель программирования. В этом случае в любой момент времени выполняется только одна операция и только над одним элементом данных. Последовательная модель универсальна. Ее основными чертами являются применение стандартных языков программирования (для решения вычислительных задач это, обычно, FORTRAN 90/95 и C/C++), хорошая переносимость программ и невысокая производительность.

Появление в середине шестидесятых годов прошлого столетия первого векторного компьютера, разработанного в фирме CDC знаменитым Сеймуром Креем, ознаменовало рождение новой архитектуры. Основная идея, положенная в ее основу, заключалась в распараллеливании процесса обработки данных, когда одна и та же операция применяется одновременно к массиву (вектору) значений. В этом случае можно надеяться на определенный выигрыш в скорости вычислений. Идея параллелизма оказалась плодотворной и нашла воплощение на разных уровнях функционирования компьютера . В настоящее время, строго говоря, уже нет исключительно последовательных архитектур; параллелизм применяется на разных уровнях, а с параллелизмом на уровне команд приходится сталкиваться любому пользователю современного персонального компьютера.

Основными особенностями модели параллельного программирования являются более высокая производительность программ, применение специальных приемов программирования и, как следствие, более высокая трудоемкость программирования, проблемы с переносимостью программ. Параллельная модель не обладает свойством универсальности.

Рисунок 4 - Модель задача/канал

В параллельной модели программирования появляются проблемы, непривычные для программиста, привыкшего заниматься последовательным программированием. Среди них: управление работой множества процессоров, организация межпроцессорных пересылок данных и т. д. Можно сформулировать четыре фундаментальных требования к параллельным программам: параллелизм, масштабируемость, локальность и модульность.

В простейшей модели параллельного программирования, она называется моделью задача/канал (Рисунок 4), программа состоит из нескольких задач, связанных между собой каналами коммуникации и выполняющихся одновременно. Каждая задача состоит из последовательного кода и локальной памяти. Можно считать, что задача — это виртуальная фон-неймановская машина. Набор входных и выходных портов определяет ее интерфейс с окружением. Канал - это очередь сообщений-посылок с данными. Задача может поместить в очередь свое сообщение или, наоборот, удалить сообщение, приняв содержащиеся в нем данные.

Количество задач может меняться в процессе выполнения. Кроме считывания и записи данных в локальную память каждая задача может посылать и принимать сообщения, порождать новые задачи и завершать их выполнения.

Лекция 8. Понятие о параллельных вычислениях

Цель лекции: Знакомство с методами параллельной обработки данных и с возможностями параллельных вычислений.

Содержание лекции: Понятие о параллельной обработке данных и параллельных вычислениях. Конвейерная обработка данных. Понятие об информационной зависимости.

Параллельная обработка данных основана на идее одновременного выполнения нескольких действий. Она имеет две разновидности:

- конвейерная обработка данных;

- собственно параллельная обработка данных.

Параллельная обработка. Если некоторое устройство выполняет одну операцию за единицу времени, то тысячу операций оно выполняет за тысячу единиц времени. А если предположить, что имеется пять таких же независимо работающих устройств, то ту же тысячу операций система из пяти устройств может выполнить за двести единиц времени.

Примеров параллельной обработки можно найти в обычной жизни: множество кассовых аппаратов в супермаркете, несколько бензиновых колонок в автозаправочных станциях, многополосное движение по автотрассам, бригада зерноуборочных комбайнов и многих других.

Одним из первых, кто использовал параллельную обработку данных, был знаменитый ученый-математик Александр Андреевич Самарский. Для моделирования сложных процессов как ядерный взрыв он в 50-ые годы посадил несколько десятков человек с арифмометрами за столы. Каждый человек передавал данные друг другу просто на словах, и откладывали необходимые цифры на арифмометрах. С помощью такой вычислительной системы была рассчитана эволюция взрывной волны. Развитие процесса обработки во времени схематично изображено на следующем рисунке:

|

. . . a4 a3 a2 a1 → . . . b4 b3 b2 b1 → |

+ |

→ 0-й такт |

|

. . . a5 a4 a3 a2 → . . . b5 b4 b3 b2 → |

a1+b1 |

→ 1-й такт |

|

. . . a5 a4 a3 a2 → . . . b5 b4 b3 b2 → |

a1+b1 |

→ 2-й такт |

|

. . . a5 a4 a3 a2 → . . . b5 b4 b3 b2 → |

a1+b1 |

→ 3-й такт |

|

. . . a5 a4 a3 a2 → . . . b5 b4 b3 b2 → |

a1+b1 |

→ 4-й такт |

|

. . . a5 a4 a3 a2 → . . . b5 b4 b3 b2 → |

a1+b1 |

→ 5-й такт |

|

. . . a6 a5 a4 a3 → . . . b6 b5 b4 b3 → |

a2+b2 |

→ c1 6-й такт |

|

. . . a6 a5 a4 a3 → . . . b6 b5 b4 b3 → |

a2+b2 |

→ c1 7-й такт |

. . . . . . . . . . . . . . .

|

. . . a6 a5 a4 a3 → . . . b6 b5 b4 b3 → |

a2+b2 |

→ c1 10-й такт |

|

. . . a7 a6 a5 a4 → . . . b7 b6 b5 b4 → |

a3+b3 |

→ c2 c1 11-й такт |

. . . . . . . . . . . . . . .

Рисунок 4.1 – Суммирование векторов C=A+B с помощью последовательного устройства, выполняющего одну операцию за пять тактов

Конвейерная обработка. Пусть рассматривается сложение двух вещественных чисел. При этом выполняется множество операций:

- сравнение и выравнивание порядков;

- сложение мантисс;

- нормализация;

- сложение нормализованных чисел и т.д.

Обыкновенные компьютеры выполняют эти операции последовательно одна за другой до тех пор, пока не доходили до окончательного результата. Только после этого переходит к выполнению других операций.

Идея конвейерной обработки данных заключается в выделении отдельных этапов выполнения общей операции, причем каждый этап, выполнив свою работу, передает результат следующему, одновременно принимая новую порцию входных данных. Каждый этап называется ступенью конвейера, а общее количество ступеней называется длиной конвейера. Получается очевидный выигрыш в скорости обработки данных за счет совмещения прежде разнесенных во времени операций.

Пример. Допустим, что в операции можно выделить 5 микроопераций, каждая из которых выполняется за единицу времени. Если эти операции выполняется одним неделимым последовательным устройством, то 100 пар аргументов оно обрабатывает за 500 единиц времени. Если же каждую микрооперацию выделить в отдельный этап конвейерного устройства, то на пятой единице времени, на разной стадии обработки такого устройства будут находиться пять пар аргументов. Первый результат будет получен через 5 единиц времени, а каждый следующий результат через единицу времени после предыдущего. Тогда весь набор из 100 пар аргументов будет обработан за 5+99 =104 единицы времени. Отсюда видно, что время конвейерной обработки данных намного меньше, чем время обработки на последовательном устройстве. В данном примере почти 5 раз. Это зависит от количества ступеней, т.е. количества этапов конвейерного устройства.

Теперь пусть рассматривается общий случай. Пусть конвейерное устройство содержит m ступеней (этапов). Каждая ступень срабатывает за одну единицу времени. Тогда время обработки n независимых операций этим устройством составит n+m-1 единиц времени. Если это же устройство использовать в монопольном режиме, т.е. в последовательном режиме, то время обработки будет равно m x n. Сравнение этих величин показывает, что m x n больше n+m-1 почти m раз.

Теперь в качестве примера можно рассматривать процесс сложения двух одномерных массивов C=A+B, схематическое изображение которого показано в следующем рисунке:

|

. . . a4 a3 a2 a1 → . . . b4 b3 b2 b1 → |

|

|

|

|

|

→ 0-й такт |

|

. . . a5 a4 a3 a2 → . . . b5 b4 b3 b2 → |

a1b1 |

|

|

|

|

→ 1-й такт |

|

. . . a6 a5 a4 a3 → . . . b6 b5 b4 b3 → |

a2b2 |

a1b1 |

|

|

|

→ 2-й такт |

|

. . . a7 a6 a5 a4 → . . . b7 b6 b5 b4 → |

a3b3 |

a2b2 |

a1b1 |

|

|

→ 3-й такт |

|

. . . a8 a7 a6 a5 → . . . b8 b7 b6 b5 → |

a4b4 |

a3b3 |

a2b2 |

a1b1 |

|

→ 4-й такт |

|

. . . a9 a8 a7 a6 → . . . b9 b8 b7 b6 → |

a5b5 |

a4b4 |

a3b3 |

a2b2 |

a1b1 |

→ 5-й такт |

|

. . . a10 a9 a8 a7 → . . . b10 b9 b8 b7 → |

a6b6 |

a5b5 |

a4b4 |

a3b3 |

a2b2 |

→ c1 6-й такт |

|

. . . a11 a10 a9 a8 → . . . b11 b10 b9 b8 → |

a7b7 |

a6b6 |

a5b5 |

a4b4 |

a3b3 |

→ c2 c1 7-й такт |

|

. . . a12 a11 a10 a9 → . . . b12 b11 b10 b9 → |

a8b8 |

a7b7 |

a6b6 |

a5b5 |

a4b4 |

→ c3 c2 c1 8-й такт |

Рисунок 4.2 – Суммирование векторов C=A+B с помощью конвейерного устройства. Каждая из пяти ступеней конвейера срабатывает за один такт.

Сведения об информационной зависимости. Для того чтобы написать параллельную программу, необходимо выделить в ней группы операций, которые могут вычисляться одновременно и независимо разными процессорами, функциональными устройствами или же разными ступенями конвейера.

Возможность этого определяется наличием или отсутствием в программе истинных информационных зависимостей. Допустим, что под операцией считается либо отдельное срабатывание некоторого оператора, либо некоторые куски кода программы.

Две операции в программе называются информационно зависимыми, если результат выполнения одной операции используется в качестве аргумента другой операции. Это очевидно, что если какие-то результаты операции A используются в операции B, то операция B может выполнена только по завершении операции A. Если операции A и B не являются информационно независимыми, то алгоритмом не накладывается никаких ограничений на порядок их выполнения. Они могут быть выполнены одновременно. Таким образом, возникает возможность распараллеливания программы, для чего должны быть определены информационно независимые операции, распределение их между вычислительными устройствами, обеспечить синхронизацию и необходимых коммуникаций.

Как видно, что понятие информационной зависимости достаточно простое. Однако исследование всего набора информационных зависимостей, существующих в конкретной программе, является весьма сложной задачей. Например, программа состоит из десятка тысяч операторов. Здесь требуется учесть, что каждый цикл может состоять из большого количества итераций. Поэтому сложность данной задачи очевидна. Для того чтобы формализовать данную задачу и облегчить анализ, вводится понятие графов информационных зависимостей.

Некоторые сведения о графах. Среди дисциплин и методов дискретной математики теория графов и алгоритмы на графах находят наиболее широкое применение в программировании. Потому что теория графов представляет очень удобный язык для описания программных моделей. Стройная система специальных терминов и обозначений упрощает изложение теории и делает ее понятной, позволяет просто и доступно описывать сложные и тонкие понятия. Название «граф» подразумевает наличие графической интерпретации.

Основоположники теории графов ставили и решали следующие известные из школьной математики задачи, которые стали классическими. К ним относятся:

- задача о Кенигсбергских мостах;

- задача о трех домах и трех колодцах;

- задача о четырех красках.

Графом G(V,E) называется совокупность двух множеств: непустого множества V и множества E неупорядоченных пар различных элементов множества V. Множество V называется множеством вершин, множество E называется множеством ребер. Число вершин графа G обозначено p, а число ребер – q.

![]()

![]() 0; E

0; E![]() V x V, E = E-1; p:= p(G) := |V|; q:= q(G):= |E|.

V x V, E = E-1; p:= p(G) := |V|; q:= q(G):= |E|.

Граф изображается диаграммой: вершины точками или кружком, а ребра - линиями.

Когда рассматриваются программы, то вершинами в графах обычно являются некоторые операции программы. Если между двумя операциями существует информационная зависимость, то соответствующие этим операциям вершины соединяются направленной дугой, началом которой является вершина-поставщик информации, а концом является вершина-потребитель информации.

Для упрощения исследования графа зависимостей в нем выделяется подграф, имеющий минимальное число дуг при выполнении следующего условия: если две вершины графа зависимостей связаны путем, то они должны быть связаны путем и в выделенном подграфе, который называется минимальным графом зависимостей. С помощью минимальных графов зависимостей можно решать все те же задачи, которые можно решать и с помощью обычных графов зависимостей. Однако они намного проще и в большинстве случаев позволяют производить эффективный анализ структуры зависимостей программы.

Если вершинам графа соответствуют отдельные срабатывания операторов программы, то такой граф называется информационной историей выполнения программы. Информационная история содержит максимально подробную информацию о структуре информационных зависимостей анализируемой программы. Поэтому она используется при анализе программ с целью распараллеливания. Однако сложность анализа такова, что если в простых случаях можно построить и проанализировать получающийся граф вручную, то для больших реальных программ необходимы инструментальные программные средства.

Эффективность конвейерной обработки данных. Как и прежде, пусть конвейерное устройство состоит из m ступеней, срабатывающих за один такт. Два вектора из n элементов можно сложить одной векторной командой. либо выполнить подряд n скалярных команд сложения элементов этих векторов.

Если n скалярных команд одна за другой исполняется на таком устройстве, то они будут обработаны за m+n-1 тактов. На практике выдержать ритм, определяемый этой формулой, довольно сложно:

- каждый такт нужно обеспечивать новые входные данные;

- сохранять результат;

- проверять необходимость повторной итерации;

- увеличивать значения индексов и т.д.

В итоге, необходимость выполнения множества вспомогательных операций приводит к тому, что становится невозможным каждый такт подавать входные данные на вход конвейерного устройства. Все это приводит к снижению эффективности работы устройства.

Если

используется векторные команды, то в формулу добавляется еще одно слагаемое: n+m+![]() -1. Здесь

-1. Здесь ![]() - время, необходимое

для инициализации векторной команды. Это означает, что для небольших значений

n

соответствующие векторные команды выгоднее исполнять в обычном

скалярном режиме, чем в векторном режиме.

- время, необходимое

для инициализации векторной команды. Это означает, что для небольших значений

n

соответствующие векторные команды выгоднее исполнять в обычном

скалярном режиме, чем в векторном режиме.

![]()

![]()

![]()

![]() E

E

Eпик=1/![]() пиковая

производительность

пиковая

производительность

0 n

Рисунок 3 – Зависимость производительности конвейерного устройства от длины входного набора данных

Так

как ![]() и m не зависят от n, то с

увеличением длины входных векторов эффективность конвейерной обработки

увеличивается. Здесь под эффективностью понимают реальную производительность E конвейерного

устройства. Она равна отношению числа выполненных операций n к времени их

выполнения. Тогда зависимость производительности от длины входных векторов

определяется следующей формулой:

и m не зависят от n, то с

увеличением длины входных векторов эффективность конвейерной обработки

увеличивается. Здесь под эффективностью понимают реальную производительность E конвейерного

устройства. Она равна отношению числа выполненных операций n к времени их

выполнения. Тогда зависимость производительности от длины входных векторов

определяется следующей формулой:

где

![]() время такта

работы компьютера.

время такта

работы компьютера.

Следует отметить, что пиковая производительность конвейерного устройства никогда недостижима на практике. Этот факт показан на рисунке 2.3, где значение производительности E растет из-за роста длины n входного набора данных, однако ее график асимптотически стремится к пиковой значения Eпик.

Лекция 9. Использование параллелизма

Цель лекции: Изучение разработки алгоритмов различных форм параллельных вычислений.

Содержание лекции: Ярусно-параллельная форма программы. Крупноблочное распараллеливание.

На прошлой лекции было введено понятие об информационной истории выполнения программы. Информационная история содержит максимально подробную информацию о структуре информационных зависимостей анализируемой программы.

Допустим, что каким-то образом удалось строить и исследовать информационную историю выполнения программы. Выделяют в ней множества информационно независимых операций, в результате возникает вопрос: каким же образом распределять эти множества между процессорами или другими обрабатывающими устройствами?

Ответ на этот вопрос будет следующим:

1. Выделяют в информационной истории те операции, которые зависят только от внешних данных программы. Будут считаться, что такие операции принадлежат первому ярусу информационной истории.

2. На второй ярус помещают операции, зависящие только от операций первого яруса и внешних данных.

Продолжая данное распределение операции информационной истории, таким образом, можно получить вид, который называется ярусно-параллельной формой программы. Количество ярусов данной формы называется длиной критического пути. Операции, попавшие на один ярус, не могут быть взаимно зависимыми, поэтому они выполняются одновременно.

Отсюда следует, что процесс получения параллельной программы может быть следующим:

1. Вначале операции первого яруса распределяются между процессорами.

2. После завершения их, операции второго яруса и т.д.

Поскольку любая операция n - го яруса зависит хотя бы от одной операции (n-1) – го яруса, то ее нельзя начать выполнять раньше, чем завершиться выполнение операций предыдущего яруса. Поэтому ярусно-параллельная форма представляет собой в определенном смысле максимально параллельную реализацию программы. При этом длина критического пути характеризует количество параллельных шагов, необходимых для ее выполнения.

Однако использование ярусно-параллельной формы связано с определенными трудностями. Причиной этого является то, что этот способ описания распараллеливания плохо согласован с конструкциями языков программирования и с архитектурными особенностями современных компьютеров. Поэтому на практике используются другие способы распараллеливания.

Крупноблочное распараллеливание. Самым простым вариантом распределения работ между процессорами является примерно следующая конструкция, называемая «крупноблочным распараллеливанием»:

if (MyProc ==0) {/*операции, выполняемые 0-ым процессором */}

. . .

if (MyProc ==k) {/*операции, выполняемые k-ым процессором */}

. . .

При этом предполагается, что каждый процессор должен иметь уникальный номер, который должен быть присвоен переменной MyProc и использовать в дальнейшем для получения участка кода для независимого исполнения. Таким образом, в приведенном примере операции в первых фигурных скобках будут выполнены только процессором с номером 0, операции во вторых фигурных скобках – процессором с номером k и т.д. При этом необходимо, чтобы одновременно разные процессоры могли выполнять только блоки информационно независимых операций, что может потребовать операций синхронизации процессоров. Кроме этого, при необходимости нужно обеспечивать обмен данными между процессорами.

Низкоуровневое распараллеливание. Однако не всегда удается выделить в программе достаточно большое число блоков независимых операций. Это означает, что при значительном числе процессоров в используемом компьютере, часть из них будет простаивать. Поэтому наряду с крупноблочным распараллеливанием используется способ низкоуровневого распараллеливания.

Из практики программирования известно, что наибольший ресурс параллелизма сосредоточен в циклах. Поэтому наиболее распространенным способом распараллеливания является то или иное распределение итераций циклов. Если между итерациями некоторого цикла нет информационных зависимостей, то их можно раздать разным процессорам для одновременного исполнения.

Условно это может быть выражено примерно следующей конструкцией:

for (i=0; i<N; i++) {

if (i – MyProc) {

/* операции i-ой итерации для выполнения процессором */

}

}

Здесь конструкция i-MyProc применена для того, чтобы номер итерации i каким-то образом соотносится с номером процессора MyProc. Конкретный способ задания этого соотношения определяет то, какие итерации цикла на какие процессоры будут распределяться. В принципе, можно раздать всем процессорам по одной итерации, а остальные итерации выполнить каким-то одним процессором. Тогда все процессоры после выполнения своих итераций будут простаивать, а один процессор будет работать. Это не эффективно. Поэтому одним из требований к распределению итераций является по возможности равномерная загрузка процессоров. Способы распределения итераций циклов в какой-то мере удовлетворяют этому требованию.

Блочно-циклическое распределение итераций. Распределение итераций цикла можно вести блоками последовательных итераций. Такое распределение называется блочным распределением. Пусть количество итераций равно N , а количество процессоров равно p. Количество итераций делится на число процессоров и число [N/p] будет количеством итераций в блоке. [N/p] – округление до ближайшего целого сверху. При этом все процессоры получают одинаковое количество итераций, однако некоторые процессоры будут простаивать.

Выбор меньшего размера блока может уменьшить этот дисбаланс. Однако при этом часть итераций останется нераспределенной. Если нераспределенные итерации снова распределять такими же блоками, начиная с первого процессора, то будет получено блочно-циклическое распределение итераций. Если уменьшать количество итераций дальше, то можно дойти до распределения по одной итерации. такое распределение называется циклическим распределением. Циклическое распределение уменьшает дисбаланс в загрузке процессоров, возникавший при блочных распределениях.

Пример. Пусть требуется распределить по процессорам итерации следующего цикла:

for (i=0; i<N; i++)

a[i] =a[i]+b[];

Пусть в компьютере имеется p процессоров с номерами 0 . . .p-1. Тогда блочное распределение итераций этого цикла можно записать следующим образом:

k = (n-1)/p +1; /* */

ibeg = MyProc * k; /* */

iend = (MyProc +1)*k-1; /* MyProc*/

if (ibeg>=N) iend = ibeg -1; /* */

else if (iend>=N) iend =N-1; /* */

for (i=ibeg; i<=iend; i++)

a[i] = a[i]+b[i];

Циклическое распределение итераций того же цикла можно записать так:

for (I = MyProc; i<N; i++)

a[i] = a[i] + b[i];

Следует заметить, что все соображения о распределении итераций циклов с целью достижения равномерности загрузки процессоров имеют смысл только в предположении, что распределяемые итерации приблизительно равноценны по времени исполнения. В некоторых случаях, например, при решении задач с треугольной матрицей, потребуется другие способы распределения.

Лекция 10. Проблема минимизации пересылок данных

Цель лекции: Изучение проблемы минимизации пересылок данных, распределение итераций в многомерных циклах.

Содержание лекции: Распределение итераций циклов. Анализ пространства итераций. Блочное распределение итераций. Блочно-циклическое распределение итераций.

Равномерная загрузка процессоров недостаточна для получения эффективной параллельной программы. Потому что бывает редко, когда в программе отсутствует информационная зависимость. Если же есть информационная зависимость между операциями, которые попадают на разные процессоры, то возникает проблема пересылки данных.

Пересылки данных требуют достаточное большое время для своего осуществления. Это связано созданием каналов связи между процессорами. Каналы связи могут увеличивать затрату времени на выполнения операций. Поэтому возникает задача о минимизации количества и объема необходимых пересылок данных. Например, при наличии информационных зависимостей между i - й и (i+1) -й итерациями некоторого цикла блочное распределение итераций может оказаться эффективнее циклического. Потому что при блочном распределении соседние итерации попадают на один процессор, а значит, потребуется меньшее количество пересылок, чем при циклическом распределении.

Анализ пространства итераций. В данной лекции до сих пор обсуждался вопрос о распределении итераций одномерных циклов. Однако в программах часто встречаются многомерные циклические гнезда. Каждый цикл такого гнезда может содержать некоторый ресурс параллелизма. Здесь вводится понятие пространство итераций. Пространством итераций гнезда тесновложенных циклов называют множество целочисленных векторов I, координаты которых задаются значениями параметров циклов данного гнезда. Задача распараллеливания при этом сводится к разбиению множества векторов на подмножества, которые выполняются последовательно друг за другом, но в рамках каждого такого подмножества итерации могут быть выполнены одномерно и независимо.

Среди методов анализа пространства итераций можно выделить несколько наиболее известных методов: методы гиперплоскостей, координат, параллелипипедов и пирамид.

Метод гиперплоскостей заключается в том, что пространство итераций размерности n разбивается на гиперплоскости размерности n-1 так, что все операции, соответствующие точкам одной гиперплоскости, могут выполняться одновременно и асинхронно.

Метод координат заключается в том, что пространство итераций фрагмента разбивается на гиперплоскости, ортогональные одной из координатных осей.

Метод параллелепипеда является логическим развитием двух предыдущих методов и заключается в разбиении пространства итераций на n -мерные параллелепипеды, объем которых определяет результирующее ускорение программы.

В методе пирамид выбираются итерации, вырабатывающие значения, которые далее в теле гнезда циклов не используются. Каждая такая итерация служит основанием отдельной параллельной ветви, в которую также входят все итерации, влияющие информационно на выбранную. При этом зачастую информация в разных вервях дублируется, что может привести к потере эффективности.

Пример. Пусть рассматривается следующий фрагмент программы:

for (i=1; i<N; i++)

for (j=1; j<M; j++)

a[i,j] = a[i-1,j]+a[i,j];

Пространство итераций данного фрагмента можно изобразить следующим образом:

![]() J

J

![]()

![]()

![]()

![]() M-1 * * * * . . .

*

M-1 * * * * . . .

*

. . . . . . . . . .

![]()

![]()

![]()

![]() 3 * * *

* . . . . . *

3 * * *

* . . . . . *

![]()

![]()

![]()

![]() 2 * * * * . . .

. *

2 * * * * . . .

. *

![]()

![]()

![]()

![]() 1 * * * *

. . . . *

1 * * * *

. . . . *

![]() I

I

0 1 2 3 4 N-1

Рисунок 5.1 – Пространство итераций фрагмента программы

На рисунке 6.1 звездочки соответствуют отдельным срабатываниям оператора присваивания, а стрелки показывают информационные зависимости. Отсюда видно, что разбиение пространства итераций по измерению I приведет к разрыву информационных зависимостей. Однако информационных зависимостей по измерению j нет. Поэтому возможно применение метода координат с разбиением пространства итераций гиперплоскостями, ортогональными оси j. Затем операции, попавшие в одну группу, распределяются для выполнения на один процессор целевого компьютера.

Пример. Пусть рассматривается немного усложненный вариант предыдущего примера:

for (i=1; i<N; i++)

for (j=1; j<M; j++)